概要:リアルタイム音色変換によるインタラクティブインスタレーション

展示空間では、他者の足音や声がふと集中を乱すことがある。その“ノイズ”を単なる妨害ではなく、作品の素材として扱えないかと考えたことを起点に本作を制作した。

鑑賞者の声や環境音を入力として取り込み、機械学習モデルを用いてリアルタイムで音色を変換し、空間全体へ響かせる。

鑑賞者は意図せず作品の一部を生成する存在となり、自分の行為が音響へ直結する体験が立ち上がる。

鑑賞者は意図せず作品の一部を生成する存在となり、自分の行為が音響へ直結する体験が立ち上がる。

技術構成

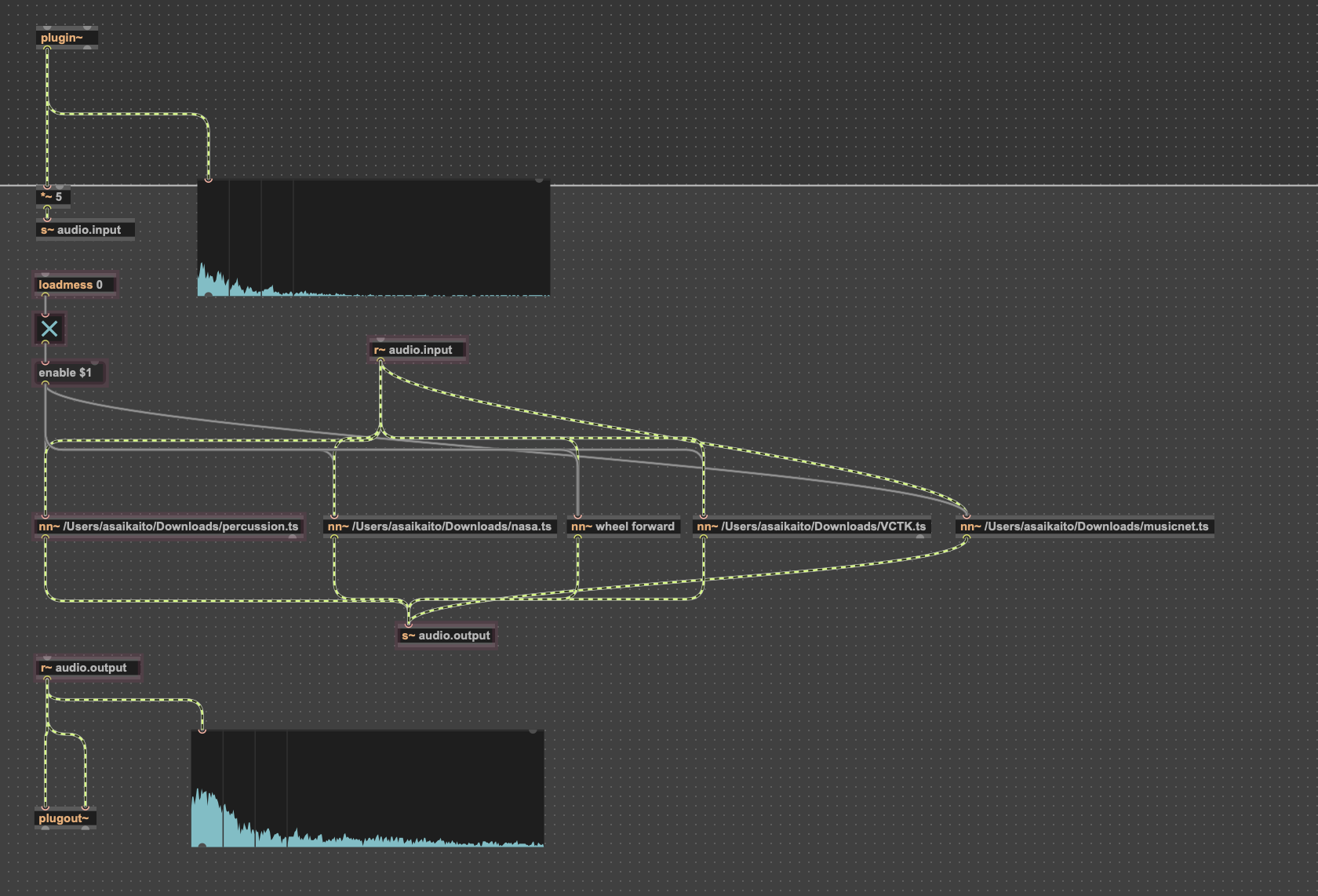

Realtime Audio Variational Autoencoder(RAVE)を用いて音色変換を実装した。

RAVE は特定の音素材を事前学習させることで、入力音を瞬時に別の質感へ変換できるモデルであり、本作では「人の声」と「ドラム」の学習済みモデルを使用している。

環境音はパーカッシブにも声的にも変容し、空間の“ノイズ”が作品の主語へと反転する。

RAVE は特定の音素材を事前学習させることで、入力音を瞬時に別の質感へ変換できるモデルであり、本作では「人の声」と「ドラム」の学習済みモデルを使用している。

環境音はパーカッシブにも声的にも変容し、空間の“ノイズ”が作品の主語へと反転する。

RAVE は Max 用に nn~ オブジェクトとして提供されているが、Windows ではビルドが必要となるため、Python を使ってモデルのビルドと実行環境を整備した。

Max で入力 → RAVE による変換 → エフェクト処理 → 空間出力という流れを構築し、低遅延で動作するよう最適化している。

Max で入力 → RAVE による変換 → エフェクト処理 → 空間出力という流れを構築し、低遅延で動作するよう最適化している。

MAXの音響処理

制作プロセス

1. 着想

自分が展示空間で感じる“他者の音への過敏さ”を逆手に取り、「集中を乱す音を創造へ変換する」テーマを設定。鑑賞者の存在そのものが作品へ介入する構造を目指した。

自分が展示空間で感じる“他者の音への過敏さ”を逆手に取り、「集中を乱す音を創造へ変換する」テーマを設定。鑑賞者の存在そのものが作品へ介入する構造を目指した。

2. システム構築

RAVE のビルドとモデルの実装、音声入出力の安定化、変換後サウンドとのバランス調整、エフェクトチェーンの設計を行い、リアルタイム性と作品の質感を同時に成立させた。

RAVE のビルドとモデルの実装、音声入出力の安定化、変換後サウンドとのバランス調整、エフェクトチェーンの設計を行い、リアルタイム性と作品の質感を同時に成立させた。